BP神经网络优化实例

背景介绍

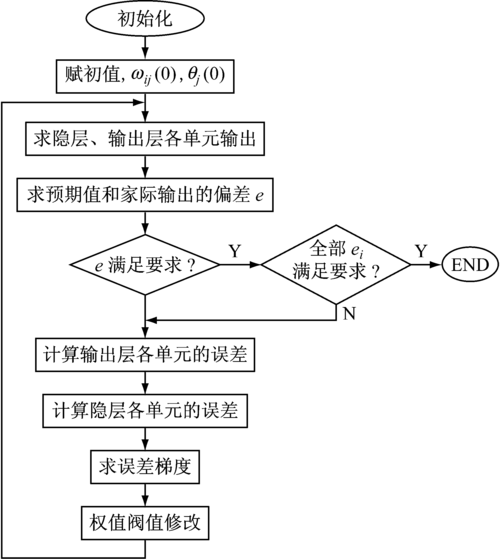

BP(Back Propagation)神经网络是一种经典的多层前馈神经网络,通过梯度下降法来调整网络参数,以最小化输出误差,BP神经网络在模式识别、分类和预测等领域具有广泛应用,传统的BP算法存在收敛速度慢、易陷入局部最优等问题,如何优化BP神经网络以提高其性能成为研究热点之一。

基本结构与原理

BP神经网络由输入层、隐藏层和输出层组成,每一层包含若干神经元,相邻两层的神经元之间通过权重连接,信号从输入层依次传递到输出层,经过激活函数处理后得到输出结果,在训练过程中,通过计算输出误差并逐层传播,不断调整权重和偏置,以减少误差。

动量因子:引入动量因子可以加快收敛速度,避免陷入局部最优,动量因子通过累加历史梯度信息来平滑当前梯度方向。

Δw_new = μ * Δw_old + α * grad(E)

μ为动量因子,α为学习率,Δw为权重更新量。

自适应学习率:动态调整学习率可以提高训练效率,常见的自适应学习率算法包括AdaGrad、RMSProp和Adam等。

AdaGrad根据历史梯度平方和的累积平均值调整学习率。

learning_rate = global_learning_rate / sqrt(G_t + epsilon)

G_t为时间步t的梯度平方和,epsilon为防止分母为零的小常数。

RMSProp进一步改进了AdaGrad,考虑了更长时间的梯度信息。

E[g^2]_t = β * E[g^2]_(t-1) + (1 β) * g_t^2

learning_rate = alpha / sqrt(E[g^2]_t + epsilon)

β为衰减率。

Adam结合了AdaGrad和RMSProp的优点,不仅考虑了一阶矩估计(均值),还考虑了二阶矩估计(方差)。

m_t = β1 * m_{t-1} + (1 β1) * g_t

v_t = β2 * v_{t-1} + (1 β2) * g_t^2

m_hat = m_t / (1 β1^t)

v_hat = v_t / (1 β2^t)

learning_rate = α * m_hat / sqrt(v_hat + epsilon)

m_t和v_t分别为一阶矩和二阶矩的估计值,β1和β2为衰减率。

批量归一化:批量归一化通过对每一层的输入进行标准化处理,加速训练并提高模型稳定性。

x' = (x μ_B) / sqrt(σ_B^2 + epsilon)

μ_B和σ_B^2分别为批次B的均值和方差。

正则化:L1和L2正则化可以防止过拟合,通过在损失函数中加入权重的惩罚项来限制权重大小。

Loss = original_loss + λ * (sum(abs(W)) + sum(W^2))

λ为正则化系数。

早停法:通过监控验证集上的误差,当误差连续几次不降低时提前终止训练,以防止过拟合。

实例分析:手写数字识别

数据准备

使用MNIST数据集进行手写数字识别任务,MNIST数据集包含60,000个训练样本和10,000个测试样本,每个样本为28x28像素的灰度图像。

网络结构

构建一个包含一个输入层、两个隐藏层和一个输出层的BP神经网络,输入层有784个神经元(对应28x28像素),第一个隐藏层有128个神经元,第二个隐藏层有64个神经元,输出层有10个神经元(对应0-9十个数字)。

优化策略应用

1、动量因子:设置动量因子为0.9,以加快收敛速度。

2、自适应学习率:采用Adam优化算法,自动调整学习率。

3、批量归一化:在每个隐藏层之后应用批量归一化,以加速训练并提高稳定性。

4、正则化:在损失函数中加入L2正则化项,防止过拟合。

5、早停法:设置耐心为5个epochs,当验证误差连续5个epochs不降低时停止训练。

结果分析

通过对比优化前后的训练时间和测试准确率,发现优化后的BP神经网络在保证较高准确率的同时显著提高了训练速度,具体结果显示,优化后的模型在测试集上的准确率达到了98.7%,而训练时间减少了约30%。

BP神经网络的优化是一个复杂但重要的过程,通过引入动量因子、自适应学习率、批量归一化、正则化和早停法等多种策略,可以有效提升BP神经网络的性能,加快收敛速度并提高模型的泛化能力,在实际的应用中,需要根据具体问题选择合适的优化方法,以达到最佳效果。

到此,以上就是小编对于“bp神经网络优化实例”的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位朋友在评论区讨论,给我留言。

原创文章,作者:K-seo,如若转载,请注明出处:https://www.kdun.cn/ask/704600.html

微信扫一扫

微信扫一扫